DeepSeek-R1 on Cursor with Ollama

各位,使用本地 llm 的方法有很多,但 DeepSeek-R1 几周前就停止更新了。如果你想在光标中使用 ollama/本地 llm,我这里有办法。

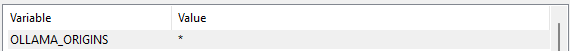

首先你需要一个 Ollama,安装Ollama之后,你需要为 Ollama 配置 CORS,否则光标会显示403 Forbidden 错误。正如你所看到的,我们需要OLLAMA_ORIGINS在 Windows 环境中进行定义。

好的,接下来我们需要 deepseek-r1 模型,我尝试了 deepseek-r1:8b,因为这个模型在我的电脑上运行基准测试效果很好,我的电脑配置是 Nvidia RTX 3070 8GB 显卡(显存足够,我达到了 60-70t/s)。我们可以使用

ollama run deepseek-r1:8b

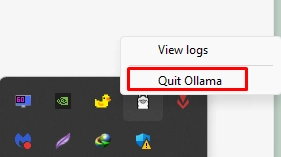

然后模型开始下载,如果一切正常,我们可以通过托盘图标窗口或其他方式退出 Ollama,我们需要关闭它才能重新启动 Ollama,因为我们定义了 CORS。

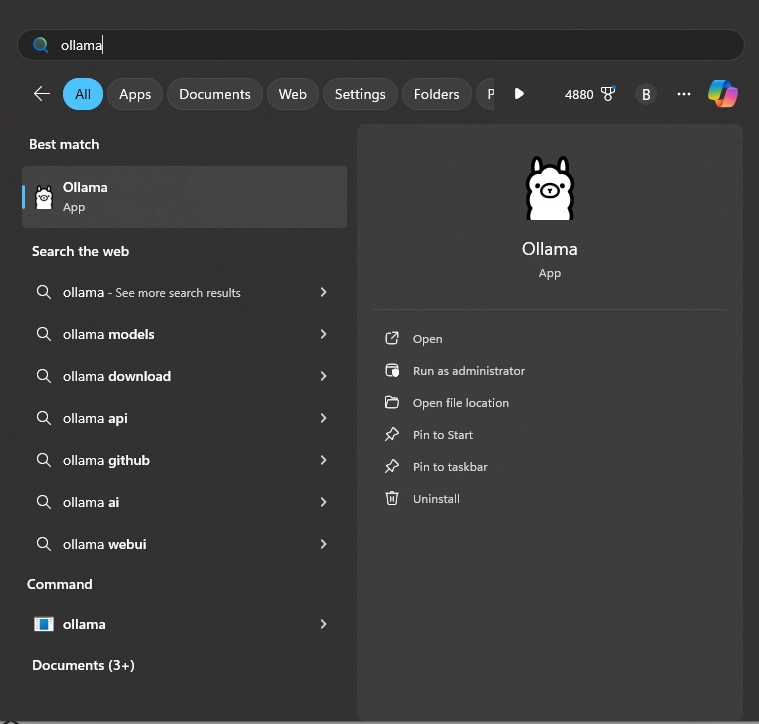

然后你就可以通过开始菜单运行 Ollama 了。

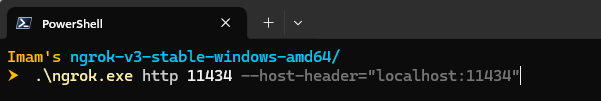

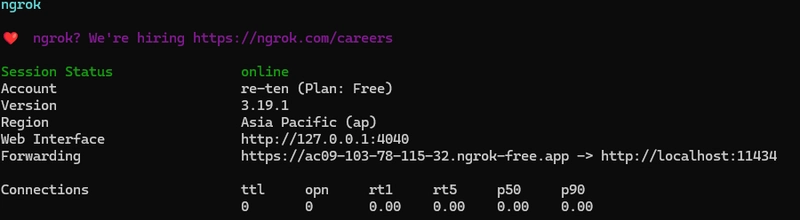

默认情况下,Ollama 会提供服务端点http://127.0.0.1:11434,但如果您直接使用该端点访问 Cursor,则无法使用。因此,我们需要ngrok。您可以下载并登录 ngrok,然后它会指导您使用身份验证令牌登录。

接下来我们需要 ngrok 为 ollama 提供公共 URL。.\ngrok.exe http 11434 --host-header="localhost:11434"

然后我们得到了 OpenAI 公共 URL 的端点

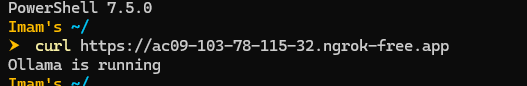

您可以检查您的端点是否处于活动状态。

好的,我们移到光标处

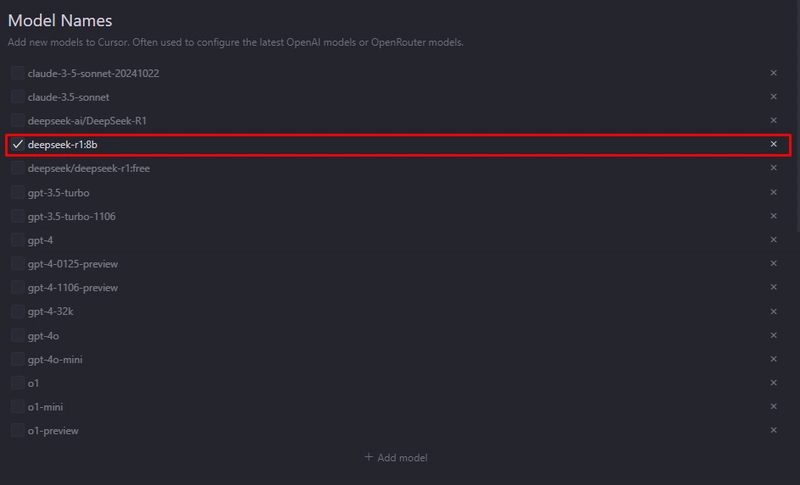

我们需要定义游标中使用的模型,您可以查看ollama list您拥有的模型列表。

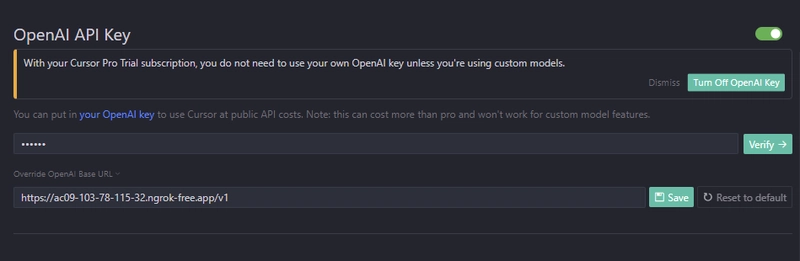

在 OpenAI Key 上使用你的公共 URLhttps://xxxxxx.ngrok-free.app和 API 密钥ollama,就完成了。

如果这一步完成,我们就可以尝试一些带有光标聊天功能的模型了。

如您所见,本地 llm 在某些情况下可以正常工作,但不支持组合,因为光标仅允许 antrophic 和 gpt 模型。